Content

Font: Kran77 / Dreamstime.com

Emportar:

Els models d’aprenentatge profund ensenyen a les computadores a pensar per si soles, amb uns resultats molt divertits i interessants.

L’aprenentatge profund s’està aplicant a cada vegada més dominis i indústries. Des dels cotxes sense conductor, passant a la reproducció de Go, a la generació d’imatges de música, cada dia hi ha nous models d’aprenentatge profund. Aquí passem per sobre diversos models populars d’aprenentatge profund. Científics i desenvolupadors prenen aquests models i els modifiquen de maneres noves i creatives. Esperem que aquest aparador us pugui inspirar per veure què és possible. (Per obtenir informació sobre els avenços en intel·ligència artificial, vegeu ¿Els ordinadors seran capaços d’imitar el cervell humà?)

Estil Neural

No podeu millorar les vostres habilitats de programació quan ningú es preocupa per la qualitat del programari.

Neural Storyteller

Neural Storyteller és un model que, quan es dóna una imatge, pot generar una història romàntica sobre la imatge. És una joguina divertida i, tanmateix, podeu imaginar el futur i veure la direcció en què es mouen tots aquests models d’intel·ligència artificial.

La funció anterior és l'operació "canvi d'estil" que permet al model transferir els subtítols d'imatge estàndard a l'estil d'històries de les novel·les. El canvi d'estil es va inspirar en "Un algorisme neuronal d'estil artístic".

Dades

Hi ha dues fonts principals de dades que s’utilitzen en aquest model. MSCOCO és un conjunt de dades de Microsoft que conté al voltant de 300.000 imatges, amb cada imatge que conté cinc subtítols. El MSCOCO és l'única informació supervisada que s'utilitza, és a dir, és l'única dada on els humans havien d'anar i escriure explícitament els subtítols per a cada imatge.

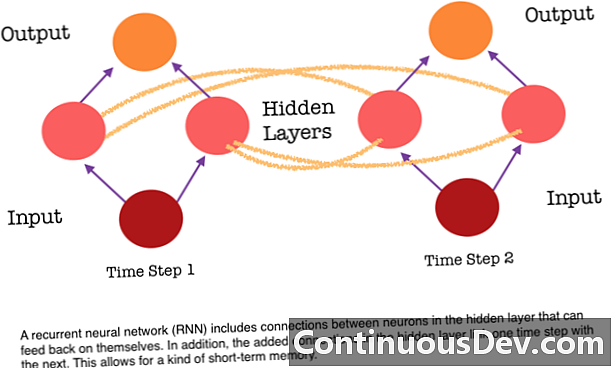

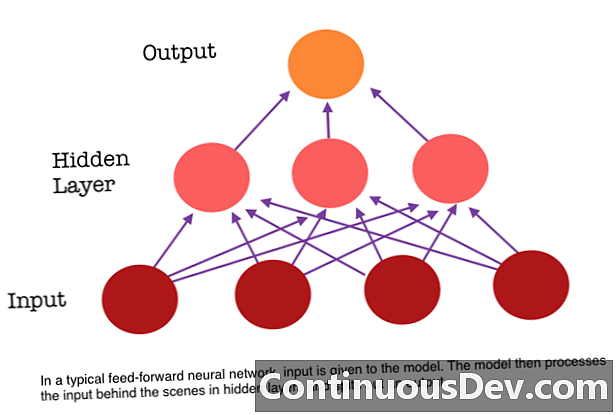

Una de les principals limitacions d'una xarxa neuronal de feed-forward és que no té memòria. Cada predicció és independent dels càlculs anteriors, com si es tractés de la primera i única predicció de la xarxa. Però, per a moltes tasques, com ara traduir una frase o paràgraf, les entrades haurien de constar de dades seqüencials i relacionades de forma conjunta. Per exemple, seria difícil tenir sentit d’una sola paraula en una frase sense la connexió que proporcionen les paraules que l’envolten.

Les RNN són diferents perquè afegeixen un altre conjunt de connexions entre les neurones. Aquests enllaços permeten que les activacions de les neurones d'una capa oculta es retroalimentin en el següent pas de la seqüència. Dit d'una altra manera, a cada pas, una capa oculta rep l'activació de la capa que hi ha a sota i també del pas anterior de la seqüència. Aquesta estructura proporciona essencialment memòria de xarxes neuronals recurrents. Així, per a la tasca de detecció d'objectes, un RNN pot utilitzar les seves classificacions anteriors de gossos per ajudar a determinar si la imatge actual és un gos.

Char-RNN TED

Aquesta estructura flexible de la capa oculta permet que les RNNs siguin molt bones per a models de llenguatge a nivell de caràcters. Char RNN, originalment creat per Andrej Karpathy, és un model que pren un fitxer com a entrada i entrena una RNN per aprendre a predir el següent personatge en una seqüència. La RNN pot generar caràcter per personatge que semblarà a les dades de formació originals. S'ha entrenat una demostració mitjançant transcripcions de diverses converses de TED. Alimenteu el model d’una o diverses paraules clau i generarà un passatge sobre les paraules clau (s) en la veu / l’estil d’un TED Talk.

Conclusió

Aquests models mostren nous avenços en la intel·ligència de màquines que s’ha fet possible a causa d’un aprenentatge profund. L’aprenentatge profund demostra que podem resoldre problemes que mai podríem resoldre abans i encara no hem arribat a aquest altiplà. Espereu veure moltes coses més emocionants, com els cotxes sense conductor durant els propers dos anys, com a resultat de la innovació profunda en l'aprenentatge.