Content

P:

Per què sovint són difícils d’entrenar les xarxes neuronals recurrents artificials?

R:

La dificultat d’entrenar xarxes neuronals recurrents artificials té a veure amb la seva complexitat.

Una de les maneres més senzilles d’explicar per què són difícils d’entrenar les xarxes neuronals recurrents és que no són xarxes neuronals pròpies.

A les xarxes neuronals prèvies, els senyals només es mouen d'una manera. El senyal es mou des d’una capa d’entrada a diverses capes ocultes i cap endavant a la capa de sortida d’un sistema.

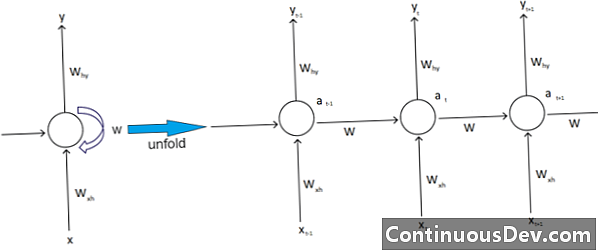

Per contra, les xarxes neuronals recurrents i altres tipus diferents de xarxes neuronals tenen moviments de senyal més complexos. Classificades com a xarxes de "retroalimentació", les xarxes neuronals recurrents poden tenir senyals que viatgen cap endavant i enrere i poden contenir diversos "bucles" a la xarxa on es retroben números o valors a la xarxa. Els experts ho relacionen amb l'aspecte de les xarxes neuronals recurrents associades a la seva memòria.

A més, hi ha un altre tipus de complexitat que afecta les xarxes neuronals recurrents. Un excel·lent exemple d’això es troba en el camp del processament del llenguatge natural.

En un sofisticat processament del llenguatge natural, la xarxa neuronal ha de ser capaç de recordar les coses. També ha de tenir entrades en contra. Suposem que hi ha un programa que vol analitzar o predir una paraula dins d’una frase d’altres paraules. Pot ser, per exemple, una longitud fixa de cinc paraules que el sistema pugui avaluar. Això vol dir que la xarxa neuronal ha de tenir entrades per a cadascuna d’aquestes paraules, juntament amb la capacitat de “recordar” o formar-se en la paraula d’aquestes paraules. Per altres motius similars, les xarxes neuronals recurrents solen tenir aquests bucles ocults i comentaris al sistema.

Els experts lamenten que aquestes complicacions dificulten la formació de les xarxes. Una de les maneres més habituals d’explicar-ho és citant el problema de gradient que esclata i s’esvaeix. Essencialment, els pesos de la xarxa conduiran a explotar o esvair valors amb un gran nombre de passades.

El pioner de la xarxa neuronal, Geoff Hinton, explica aquest fenomen a la xarxa dient que els passos lineals endarrerits faran que els pesos més petits es redueixin exponencialment i que es faci explotar pesos més grans.

Aquest problema, continua, empitjora amb seqüències llargues i passos de temps més nombrosos, en què els senyals creixen o decauen. La inicialització del pes pot ajudar, però aquests reptes s’integren en el model de xarxa neuronal recurrent. Sempre hi haurà aquest tema relacionat amb el seu disseny i creació particular. Essencialment, alguns dels tipus més complexos de xarxes neuronals desafien realment la nostra capacitat de gestionar-les fàcilment. Podem crear una quantitat de complexitat pràcticament infinita, però sovint veiem créixer reptes de previsibilitat i escalabilitat.