Content

- Big Data no està estructurada o semiestructurada

- No hi ha cap punt per emmagatzemar dades grans si no es poden processar

- Com Hadoop resol el gran problema de dades

- El cas empresarial d’Hadoop

Emportar:

Hadoop pot ajudar a resoldre alguns grans desafiaments de grans dades.

Les dades grans són ... bé ... de mida gran! La quantitat exacta de dades que es poden classificar com a dades grans no està clarament reduïda, de manera que no es deixi caure en aquest debat. Per a una petita empresa que acostuma a tractar dades de gigabytes, 10 TB de dades serien GRANS. Tot i això, per a empreses com Yahoo, els petabytes són grans.Només la mida de les dades grans, fa que sigui impossible (o almenys costós prohibitiu) emmagatzemar-la en emmagatzematge tradicional, com bases de dades o fitxers convencionals. Estem parlant de cost per emmagatzemar gigabytes de dades. L'ús de fitxers d'emmagatzematge tradicionals pot costar molts diners per emmagatzemar grans dades.

Aquí feu una ullada a les dades grans, els seus reptes i com Hadoop pot ajudar-los a resoldre.Primer cap amunt, grans reptes de grans dades.

Big Data no està estructurada o semiestructurada

Moltes dades grans no estan estructurades. Per exemple, les dades del registre de flux clic en poden semblar:segell de temps, user_id, pàgina, referrer_page

La manca d’estructura fa que les bases de dades relacionals no s’adaptin bé per emmagatzemar dades grans. A més, no moltes bases de dades poden fer front a emmagatzemar milers de milions de files de dades.

No hi ha cap punt per emmagatzemar dades grans si no es poden processar

Emmagatzemar dades grans forma part del joc. Hem de processar-la per eliminar-ne la intel·ligència. Els sistemes d'emmagatzematge tradicionals són molt "muts" en el sentit que només emmagatzemen bits. No ofereixen cap poder de processament.El model tradicional de processament de dades té dades emmagatzemades en un clúster d’emmagatzematge, que es copia en un clúster de càlcul per al tractament. Els resultats es tornen a escriure al clúster d'emmagatzematge.

Aquest model, però, no funciona força per a dades grans perquè copiar tantes dades a un clúster de càlcul pot requerir massa temps o és impossible. Quina és la resposta?

Una solució és processar dades grans al seu lloc, com per exemple en un clúster d’emmagatzematge que es duplica com a clúster de càlcul.

Així, com hem vist més amunt, les dades grans desafien l'emmagatzematge tradicional. Llavors, com gestionem les dades grans?

Com Hadoop resol el gran problema de dades

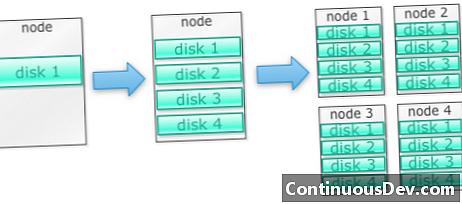

Hadoop està construït per funcionar en un cúmul de màquinesComencem amb un exemple. Diguem que és necessari emmagatzemar moltes fotos. Començarem amb un sol disc. Quan superem un disc únic, és possible que utilitzem uns quants discos apilats en una màquina. Quan rebem el màxim de tots els discos en una sola màquina, hem d’aconseguir un munt de màquines, cadascuna amb un munt de discos.

Així és exactament com es construeix Hadoop. Hadoop està dissenyat per funcionar en un grup de màquines des del primer moment.

Els cúmuls de Hadoop s’escalen horitzontalment

Es pot aconseguir més energia d’emmagatzematge i càlcul afegint més nodes a un clúster de Hadoop. Això elimina la necessitat de comprar un maquinari cada cop més potent i costós.

Hadoop pot gestionar dades no estructurades / semiestructurades

Hadoop no fa aplicar cap esquema a les dades que emmagatzema. Pot tractar dades binàries arbitràries i binàries. Així, Hadoop pot digerir qualsevol dada no estructurada fàcilment.

Els clústers Hadoop proporcionen emmagatzematge i informàtica

Vam veure com tenir emmagatzematge separat i processar clústers no és el més adequat per a dades grans. No obstant això, els clústers de Hadoop proporcionen l'emmagatzematge i la distribució informàtica tot en un.

El cas empresarial d’Hadoop

Hadoop proporciona emmagatzematge de grans dades a un cost raonable

Emmagatzemar dades grans mitjançant l'emmagatzematge tradicional pot ser car. Hadoop es basa en el maquinari de productes bàsics, de manera que pot proporcionar un emmagatzematge bastant gran per un cost raonable. Hadoop s'ha utilitzat al camp a escala de petabyte.

Un estudi de Cloudera va suggerir que les empreses solen gastar entre 25.000 i 50.000 dòlars per terabyte a l'any. Amb Hadoop, aquest cost baixa fins a uns quants milers de dòlars per terabyte a l'any. A mesura que el maquinari és cada cop més barat, aquest cost continua baixant.

Hadoop permet la captació de dades noves o més

De vegades, les organitzacions no capturen un tipus de dades, perquè era massa prohibitiu emmagatzemar-lo. Com que Hadoop proporciona emmagatzematge a un cost raonable, aquest tipus de dades es poden capturar i emmagatzemar.

Un exemple serien els registres de clics de lloc web. Com que el volum d'aquests registres pot ser molt elevat, moltes organitzacions no van capturar-les. Ara amb Hadoop és possible capturar i emmagatzemar els registres.

Amb Hadoop, podeu emmagatzemar dades més temps

Per gestionar el volum de dades emmagatzemades, les empreses purguen periòdicament dades antigues. Per exemple, només es podien emmagatzemar els registres dels darrers tres mesos, mentre que es van eliminar els registres anteriors. Amb Hadoop és possible emmagatzemar les dades històriques més temps. D’aquesta manera es poden fer noves analítiques a dades històriques més antigues.

Per exemple, feu un registre de clics des d’un lloc web. Fa uns anys, aquests registres es van desar durant un breu període de temps per calcular estadístiques com les pàgines populars. Ara amb Hadoop, és viable emmagatzemar aquests registres de clics durant un període de temps més llarg.

Hadoop proporciona anàlisis escalables

No té cap sentit emmagatzemar totes aquestes dades si no les podem analitzar. Hadoop no només proporciona emmagatzematge distribuït, sinó que també processa distribuït, cosa que significa que podem trossejar un gran volum de dades en paral·lel. El quadre de càlcul de Hadoop s'anomena MapReduce. MapReduce s'ha demostrat amb l'escala de petabytes.

Hadoop proporciona una gran analítica

Native MapReduce suporta Java com a llenguatge de programació principal. Es poden utilitzar altres idiomes com el Rubí, el Python i el R.

Per descomptat, l'escriptura de codi personalitzat MapReduce no és l'única manera d'analitzar les dades a Hadoop. Hi ha disponible Mapa Reduït de nivell superior. Per exemple, una eina anomenada Pig pren l'anglès com a llenguatge de flux de dades i les tradueix en MapReduce. Una altra eina, Hive, realitza consultes SQL i les executa mitjançant MapReduce.

Les eines d’intel·ligència empresarial (BI) poden proporcionar un nivell d’anàlisi encara més elevat. També hi ha eines per a aquest tipus d’anàlisi.

Aquest contingut està extret de "Hadoop Illuminated" per Mark Kerzner i Sujee Maniyam. S’ha posat a disposició mitjançant llicència de Reconeixement-No comercial-Compartir-Igual 3.0 no autoritzada de Creative Commons.